Tema 4. Metodología de la EpS III

Volver al Índice de Temas

OBJETIVOS:Al termino del estudio de este tema el alumno deberá:

|

ÍNDICE:

|

1. LA EVALUACIÓN

1.1. Concepto de evaluación:

La evaluación es el proceso por el que juzgamos el valor o la utilidad de alguna cosa.

1.2.- Tipos de evaluación

-

DEL PROCESO: mide las actividades del programa, la calidad del programa y a quién va dirigido.

-

DEL IMPACTO: mide el efecto inmediato del programa (¿se alcanzan sus objetivos?)

-

DE LOS RESULTADOS: mide los efectos a largo plazo del programa (¿se alcanzan sus metas?)

Estas tres formas de evaluación han de realizarse de forma consecutiva. Sería prematuro valorar los efectos a largo plazo de un programa antes de saber si éste funciona en la forma prevista, llega a las personas apropiadas y está obteniendo los efectos iniciales previstos.

1.3.- Enfoques de la evaluación: cualitativo y cuantitativo

Pueden distinguirse dos enfoques en la forma de investigar los efectos de un programa: cualitativo y cuantitativo. En el enfoque cualitativo los métodos son poco estructurados y se basan en la observación. Los enfoques cualitativos contestan a preguntas relacionadas con el por qué. Utilizan preguntas abiertas, como "¿qué le parece que produjo el programa para la gente?. Esto ayuda a entender mejor los efectos del programa. Por ejemplo: "sólo el 3% de los participantes cambiaron sus hábitos de ejercicio físico"; sin una investigación cualitativa no podremos saber a qué se debió ese resultado.

Los métodos cuantitativos responden al cuánto y nos permiten llegar a más personas y hacer comparaciones entre ellas.

Ambos enfoques tienen limitaciones. Los métodos cualitativos proporcionan muchos datos en profundidad de las personas relacionadas con el programa. Pero esto significa que sólo puede entrevistarse un número reducido de personas y que es difícil generalizar los resultados.

Con los enfoques cuantitativos es posible obtener con relativa facilidad datos de un número elevado de individuos, pero a costa de sacrificar la profundidad y el detalle de sus diversas experiencias.

2. EVALUACIÓN DEL PROCESO

La primera tarea en la evaluación del proceso consiste en asegurarse de que el programa planificado se preparó y ejecutó de acuerdo con las intenciones originales. Por muchos motivos, lo que estaba previsto en los papeles puede sufrir modificaciones. Las personas que participan en el programa pueden ser otras distintas al grupo al que estaba destinado. El personal puede variar ligeramente la estructura de las sesiones para adecuarse a nuevas necesidades. Puede faltar o cambiar el material o la película. A las personas que acuden al programa puede no gustarles, de modo que es posible que se introduzcan pequeñas mejoras o grandes alteraciones. Incluso, puede ser que sencillamente no se pueda hacer lo previsto porque en la práctica resulta demasiado difícil.

Un programa funcionará sólo si se ejecuta en la forma adecuada, llega a las personas apropiadas y éstas se muestran satisfechas con él. Por consiguiente, hay que evaluar el proceso antes de efectuar cualquier otra forma de evaluación que valores los efectos del programa.

Sería absurdo buscar los efectos de un programa que no esté funcionando de modo apropiado.

En la evaluación del proceso, tendremos que medir:

-

La valoración del alcance del programa

Esto se realiza respondiendo a las siguientes preguntas: ¿el programa llega al grupo diana?, ¿cada parte del programa llega a todas las partes del grupo diana?, etc. Habrá que elaborar registros para anotar estos datos.

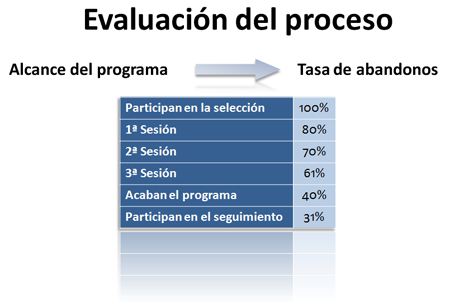

Esta valoración se realiza de manera continuada. Un indicador importante de la valoración del alcance del programa es la Tasa de abandonos.

El profesional sanitario que recoja los datos mostrados en la figura deseará encontrar formas de reducir la tasa de abandonos. Tiene que plantearse esta cuestión antes de empezar a buscar efectos globales del programa.

-

Valoración de la satisfacción de los participantes

¿Qué se mide?:

Cuestiones interpersonales: ¿se sienten cómodos, atendidos?

Relativas al servicio: local, fácil desplazamiento, horario, instalaciones, etc.

Cuestiones de contenido: temas relevantes, interesantes, ritmo lento, etc.

¿Cómo se mide?: Se puede medir con cuestionarios o entrevistas en grupo. Otra forma para mantener el anonimato es poner un cartel en la pared con el tema a tratar, aspectos positivos, aspectos negativos y sugerencias. Las personas se reúnen en grupos (5 o 10´) y aportan sus resultados. No es necesario que lleguen a un acuerdo. Las personas se sienten mejor al expresar opiniones negativas si se les brinda la oportunidad de convertir las críticas en recomendaciones o en algo constructivo.

¿Cuándo se realiza?: Al menos una vez al año o una de cada cuatro sesiones que se realicen. -

Valoración del cumplimiento de las actividades

Además de contar a los participantes que acuden a las actividades del programa, hay que comprobar si las actividades realmente se están desarrollando del modo que se definió. Se deben escribir todos los componentes del programa (sesiones,actividades, etc) e idear mecanismos para registrar y controlar si todo se lleva a cabo en la forma planteada originalmente. También es importante medir el contenido de las sesiones de educación por si hay que modificar los tiempos dedicados a cada área temática.

¿Cuándo se realiza?: Al menos una de cada seis sesiones. -

Valoración del rendimiento y de los componentes del programa Materiales:

Atracción: ¿El folleto suscita interés, capta la atención, qué gusta más y qué disgusta del folleto a la gente?

Comprensión: ¿Es fácil de entender, hay algo que confunda? Nº de polisílabos.

Aceptabilidad: ¿Hay algo en él ofensivo o irritante?, ¿entra en conflicto con normas culturales?

Implicación personal: ¿Parece dirigido personalmente al lector?

Persuasión: ¿Es convincente? ¿parece persuadir al lector de emprender alguna acción?.

¿Cuándo?: 1 de cada 4 veces en que se ejecute el programa, pero no menos de 1 vez al año.

Líderes de grupo y procesos de grupo: Los programas de promoción de la salud varían considerablemente en cuanto a la función que cumplen los monitores de grupo. en algunos programas, como lo de ejercicio físico, el monitor es un instructor. En otros programas (grupos de desarrollo personal para adolescentes o grupos de ayuda mutua) el monitor de grupo adopta un papel más discreto e intenta alcanzar el objetivo del programa facilitando la conversación, las ideas y dando apoyo interpersonal a los participantes.

Para valorar a un instructor o monitor, el cuestionario abarcará áreas como: simpatía, interés, habilidad para comunicarse y comprender, grado de organización y dirección, si comete o no errores, si es demasiado rápido, si no cuida el rigor o los detalles.

Para valorar el ambiente de grupo o clima de grupo habrá que explorar sensaciones creadas en el grupo por sus miembros y la forma en que interaccionan entre ellos.

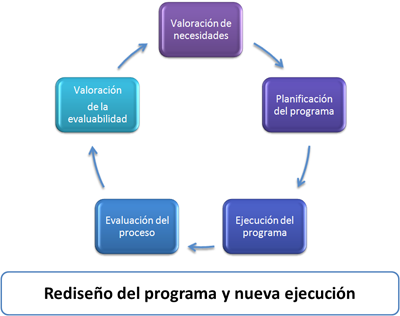

Cuando se pone en marcha un programa, la primera responsabilidad es idear sistemas que midan su alcance, su ejecución, la calidad del material que utilizan y la satisfacción de los participantes. Posteriormente se utilizará esta información para introducir cambios en los programas. Estos cambios se evalúan como parte de la evaluación del proceso hasque que el programa alcanza su nivel óptimo y estable. Después se puede entrar en la evaluación del impacto y de los resultados. La siguiente figura ilustra esta dinámica.

3. EVALUACIÓN DEL IMPACTO Y DE LOS RESULTADOS.

Tanto la evaluación del impacto como la de los resultados implica la valoración de los efectos del programa, pero de distinto modo. La evaluación del impacto suele centrarse en la valoración de los efectos inmediatos del programa y, en general, se corresponde con los objetivos del programa.

La evaluación de los resultados se centra en los efectos posteriores o a más largo plazo y, en general, se corresponde con la meta del programa.

|

Por ejemplo: Programa de rehabilitación cardiaca que intenta mejorar los hábitos dietéticos y de ejercicio de las personas que han tenido un primer infarto, con la meta de reducir la probabilidad de que tenga nuevos ataques Por ejemplo: Programa de prevención de embarazos que intenta mejorar los conocimientos de los adolescentes en métodos contraceptivos con la meta de reducir en número de embarazos no deseados. Por ejemplo: Un educador sanitario puede trabajar en un área local para intentar cambiar los conocimientos y actitudes sobre la nutrición (ev. impacto) con la meta de mejorar la dieta (ev. de resultados). En el área estatal o nacional, los planificadores e investigadores pueden estar interesados en valorar los cambios en la dieta (ev. impacto) con la meta de reducir la incidencia de la enfermedad coronaria (ev. resultados). |

La diferencia entre evaluación del impacto y evaluación de los resultados no depende tanto de lo que se mide sino de la secuencia de la medida. No todas las metas han de expresarse en términos de salud.

Los Métodos más comunes para recoger los datos para evaluar el impacto consisten en entrevistas personales, encuestas personales y cuestionarios autoadministrados.

El tema siguiente está dedicado íntegramente a conocer estos instrumentos de recogida de datos y a saber cómo se pueden realizar preguntas para valorar los diferentes constructos que nos interesan.

Sin embargo, adelantaremos algunos ejemplos de medición.

Medición de los conocimientos

Se intenta valorar qué saben las personas, qué conocen, de qué están al corriente, qué han entendido o qué han aprendido. El enfoque de cada uno de estos aspectos puede variar ligeramente.

Por ejemplo: Estamos interesados en valorar hasta qué punto la comunidad conoce una campaña de prevención del cáncer de piel y lo que ha aprendido con ella. Se decide hacer una encuesta en centros comerciales. ¿Qué tipo de preguntas habrá que plantear?. Lo primero que podemos preguntar es: ¿está usted al corriente de la campaña de prevención del cáncer de piel?, o bien, ¿ha visto u oído los anuncios sobre la prevención del cáncer de piel?.

Estas preguntas plantean el problema de que las personas tienden a contestar que sí porque advierten que esta es la pregunta deseada. Para que no adivinen nuestros intereses es mejor plantear una lista de campañas (reales y ficticias) y preguntar sucesivamente si conocen cada una de las campañas.

Podemos preguntar ¿qué ha aprendido?, pero a menos que haya personas implicadas en un curso, a la gente no le gusta que le pregunten esto porque muchas personas creen que no necesitan que les enseñen nada.

Puede ser mejor preguntar: Según la campaña, ¿qué se debe hacer para prevenir el cáncer de piel? (Aunque de esta forma lo único que sabemos es si la gente recuerda el mensaje, pero no significa que lo haya entendido).

Para valorar la comprensión puede formularse una pregunta que exija al encuestado aplicar la información aprendida a cualquier problema: Identificar en una lista de alimentos el que tenga menos grasa.

Por último, hay que tomar precauciones con los enfoques que piden a la gente que valore sus conocimientos sobre un tema al empezar un programa y al terminarlo. El programa puede cambiar no sólo sus conocimientos, sino también sus opiniones sobre la magnitud y la importancia del tema. En un curso sobre el SIDA, las enfermeras pueden valorar inicialmente que sus conocimientos sobre el tema son muy buenos y, al terminar el programa que son buenos, a pesar de que han aprendido mucho en el curso. La falta aparente de progreso puede reflejar sencillamente que al final del programa son más conscientes de las complejidades de la problemática del SIDA y que son más modestos en su valoración.

Medición de las actitudes

Mucho más difíciles de medir, porque los sentimientos son más difíciles de clasificar. Hay que fomentar su libre expresión, para lo cual los métodos cualitativos pueden resultar más útiles, especialmente al explorar un tema.

Por ejemplo: Queremos evaluar un programa para adolescentes cuya meta es la prevención del abuso de alcohol y la conducción en estado de ebriedad. Parte del programa intenta romper el estereotipo tradicional que asocia el alcohol con el pasarlo bien.

El objetivo es promover actitudes positivas sobre el ocio y las compañías sin alcohol. En la evaluación del impacto, queremos medir las opiniones de los adolescentes sobre la diversión y el alcohol, la bebida en las fiestas, el beber y el deporte, etc.

Un enfoque útil consiste en enseñar a pequeños grupos de adolescentes vídeos cortos que muestren a adolescentes rechazando el alcohol y plantearles preguntas como: ¿qué os parece esta chica?, ¿qué creéis que opinan de ella sus amigos?, etc. Si tenemos grupos más numerosos podemos utilizar cuestionarios con escala tipo Likert (ver Tema 7).

Medición del comportamiento o de la conducta

Lo más sencillo es preguntar directamente (autodeclaración). Normalmente nos da respuestas fiables.

Sin embargo, cuánto mayor es el aprecio social por una respuesta del tipo sí, lo hago, tanto más difícil será obtener una respuesta fiable en el cuestionario. Otra forma puede ser el pedir a la gente que haga una autorregistro (nº de cigarrillos fumados, consumo de alcohol, uso de medicamentos, dieta, etc.). Los psicólogos han demostrado que registrar una conducta supone reducirla, por lo que el autorregistro es una forma de intervención más que de evaluación.

También sirve la observación directa: cuántos niños respetan el paso de peatones, cuáles son los platos elegidos por los trabajadores de una empresa, etc. También se puede fotografiar el plato antes de comerlo (experiencia en Melbourne con el mantel cuadriculado).

Métodos indirectos: ventas de preservativos, fruta, etc.

4. ¿CUÁNDO SE PERCIBIRÁN LOS EFECTOS?

Los efectos no deben medirse demasiado pronto ni demasiado tarde.

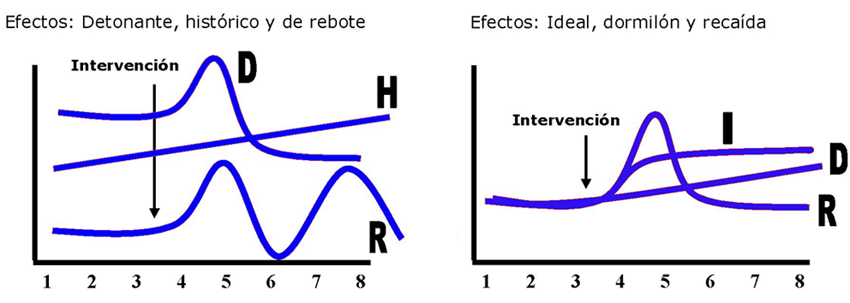

El efecto ideal consiste en conseguir una mejoría inmediata en el factor relacionado con la salud que aborda, manteniéndose a lo largo del tiempo.

Sin embargo, Green sugiere que los efectos de un programa pueden caer en alguna de las cinco categorías siguientes:

-

Efecto dormilón.

-

Efecto de recaída: el efecto es inmediato pero dura poco (programa de control de sobrepeso o abandono del hábito tabáquico donde los participantes recaen en sus hábitos anteriores si no siguen la disciplina de las sesiones anteriores.

-

Efecto detonante o gatillo: también denominado tomar prestado a cuenta del futuro, porque consigue producir antes algo que hubiera pasado de todos modos después. (Campaña en pro de la citología cervical, que logra un incremento en el número de mujeres que acuden a hacerse la citología en Agosto (lo cual parece un éxito) cuando, de hecho, estas mismas mujeres habrían acudido en Septiembre u Octubre.

-

Efecto histórico: un comportamiento mejora a lo largo del tiempo de manera natural (incremento en el consumo de productos con poca grasa, etc.).

-

Efecto de rebote: se produce cuando existe una interrupción prematura del programa que desmoraliza o irrita a los participantes, llevándoles a niveles de comportamiento o problemas peores que antes de iniciar el programa.

¿Cómo puede saberse qué patrón aplicar a cada situación concreta?

-

Consultando la bibliografía

-

Pensando en el problema con detenimiento (¿es un programa que consigue que los participantes se esmeren durante unas 2 o 3 semanas para después recaer en sus costumbres anteriores?, ¿es un programa que requiere tiempo para que los efectos maduren...?)

No hay fórmulas mágicas.

5. DISEÑOS EVALUATIVOS

¿Cómo estar seguros de que el programa es el responsable de los efectos deseados?. Leamos los ejemplos que vienen a continuación:

-

Un Centro de Salud organiza un sistema para recordar a las familias, mediante el envío de avisos, que sus hijos han de vacunarse. durante los siguientes meses, el 90% de las familias vacuna a sus hijos. el Coordinador del Centro de Salud concluye que su programa de recuerdo es un éxito.

-

Un equipo de salud comunitaria desarrolla una serie de actividades de educación contra el SIDA en residencias de estudiantes universitarios. Al final del programa el 60% de los estudiantes manifiestan que no mantendrían relaciones sexuales sin un preservativo. El equipo concluye que el programa es un éxito.

-

Una psicóloga desarrolla una serie de talleres de control del estrés para los funcionarios del Servicio Nacional de Salud (atención al público). Dos meses después del programa, los datos muestran que los niveles de estrés y las bajas por enfermedad de los funcionarios que participaron en los talleres son muy inferiores a las de los funcionarios del mismo servicios que no participaron. En su informe, la psicóloga recomienda que se organicen esos talleres de control del estrés en todos los servicios.

Hay otras explicaciones de estos efectos. En el caso de las vacunas infantiles, podría ser que el motivo de que el 90% de las familias acudiese a vacunar a sus hijos fuese que el gobierno hubiera hecho una campaña al mismo tiempo. Desconocemos cuántos estudiantes suelen usar preservativo. Los talleres pueden haber atraído sólo a los funcionarios preocupados por el estrés y dispuestos a hacer algo al respecto y capaces de hacerlo. Además, es posible que las personas que participaron sufrieran menos estrés que las que no participaron.

A continuación veremos diferentes tipos de diseños para evitar estos problemas. Seguiremos la taxonomía de Cook y Campbell:

5.1.- Mediciones postest en un solo grupo:

La medición se efectúa al final del programa y sólo en las personas que participaron en él.

Por ejemplo: Cartas circulares pidiendo que se vacunen los niños. Se vacuna el 90%. ¿se produjeron realmente los cambios o es que el 90% ya vacunaba a sus hijos? ¿cómo estar seguros de que los cambios se deben a nuestra intervención y no a otros factores?

5.2.- Mediciones pretest y postest en un solo grupo:

Está concebido para detectar cambios pero tampoco es posible estar seguro de que no se deban a ningún otro factor.

5.3.- Mediciones pretest y postest con grupo de control no equivalente:

El grupo de control no recibe el programa. Se denomina no equivalente porque las personas no tienen exactamente las mismas características que el grupo experimental. El grupo control puede proceder de otro barrio, provincia, otra sala de hospital, otro período de tiempo, etc. Puede que el programa funcione porque los del grupo control tengan nivel educativo mayor, mayor forma física, se cuiden más, etc.

5.4.- Serie temporal con un solo grupo:

Cuando no hay forma de conseguir un grupo control se utiliza este diseño. Permite observar los cambios que se producen en un grupo de forma natural antes de la intervención y después para observar efectos.

5.5.- Series temporales con grupos no equivalentes:

Es una combinación de las dos anteriores. Proporciona datos más sólidos a favor de que es el programa el que causó los cambios. Es mejor que el pretest y postest con grupo de control no equivalente porque descarta la existencia de un efecto histórico.

Por ejemplo: Comparación de petición de citologías en otros Estados donde no haya habido campaña informativa.

5.6.- Ensayo clínico aleatorizado o medición pretest y postest con grupo de control equivalente:

El grupo de control es aquel que es idéntico en todo al grupo experimental excepto en el hecho de que no recibe el programa. De acuerdo con la teoría estadística, esto sólo se puede conseguir si las personas se asignan a un grupo u otro estrictamente al azar.

Es un auténtico experimento aunque no siempre se puede hacer. Los demás son diseños cuasiexperimentales.

¿Es difícil encontrar un grupo de control equivalente?. Cuando la intervención es amplia cuesta bastante encontrar personas que no hayan estado expuestas. En estas circunstancias, el único grupo de control posible procederá de otra región, estado, etc. con lo cual habrá que considerarlo no equivalente.

6. ¿QUÉ DISEÑO ELEGIR?

Los diseños que exigen grupo de control cuestan caros y exigen recursos añadidos (investigadores, encuestadores, etc.)

Hay que asegurarse de que existe algún tipo de efecto antes de gastar recursos en medir la situación en un grupo control.

Una solución práctica y factible para este problema consiste en hacer alguna valoración preliminar de los efectos del programa, con un diseño del tipo pretest y postest con un solo grupo, antes de decidir organizar recursos para un diseño más complejo.

6.1.- Significación estadística:

Probabilidad de que un aumento o descenso se produjera por casualidad es inferior al 5%. Cuando se afirma que hay un aumento estadísticamente significativo en la proporción de niños vacunados en un barrio después de un programa, en general se quiere indicar que la probabilidad de que este aumento se produjera por casualidad es inferior al 5%. Con una probabilidad tan baja, puede considerarse razonable la conclusión de que el programa funcionó.

6.2.- Muestra:

La mejor es la aleatoria.

| Por ejemplo: Tenemos 200 participantes en un seminario de control de peso. Queremos entrevistar a 50 para saber cómo se encuentran. Si se seleccionan al azar, cada uno de ellos tiene la misma probabilidad que los demás de ser elegido. El proceso de selección es justo y no hay desviación. Se utiliza una tabla de números aleatorios que suelen aparecer en los manuales de estadística y se numera del 1 al 200. De la lista se obtienen las personas a elegir (006, 189, 023, 056, etc) hasta las 50 necesarias. |

6.2.1.- Tipos de muestra:

-

Sistemática (tomar consecutivamente 1 de cada 3 de la lista).

-

De conveniencia (personas a las que se puede acceder fácilmente).

-

En bola de nieve (para poblaciones difíciles de alcanzar)

6.2.2.- Tamaño de la muestra:

Depende de la precisión que se desee en los resultados. Cuanto mayor sea la muestra, más precisa será la estimación que se obtenga de ella.

Supongamos que encuestamos a 40 estudiantes de 14 y 15 años, de los cuales 16 (40%) manifiesta que bebe alcohol una o más veces por semana. Si consultamos a un estadístico nos dirá que sólo podemos concluir que la proporción real de bebedores en nuestra población oscila entre el 25 y el 57% (intervalos de confianza). Si necesitamos una estimación más precisa del problema, nos puede aconsejar sobre el tamaño de la muestra. En caso de ser 90 y el 40% -la proporción está entre el 30 y el 51%. Con 400, el intervalo de confianza está entre el 35-45%.

Pero, ¿debemos esforzarnos por tener estimaciones precisas?. Todo depende del objetivo de la encuesta. Si se está haciendo una valoración de las necesidades para definir los problemas de la comunidad y los factores que los condicionan antes de una intervención, puede argumentarse que la precisión de las estimaciones no es tan importante como la naturaleza real de los datos que van a recogerse y su capacidad de mostrar la dinámica del problema. Así, quizá sea más importante que los datos indiquen por qué hay chicos que beben, dónde y cuándo beben, con quién, etc, más que obtener con precisión en número real de los que beben. En el caso de que sean datos pre, habrá que saberlo con seguridad para la situación post.